Bienvenido a la sección de Big Data

Contenidos de esta página

¿Qué es Big data?

Cuando hablamos de Big Data nos referimos a conjuntos de datos o combinaciones de conjuntos de datos cuyo tamaño (volumen), complejidad (variabilidad) y velocidad de crecimiento (velocidad) dificultan su atrapa, gestión, procesamiento o análisis a través de tecnologías y herramientas usuales, como bases de datos relacionales y estadísticas usuales o paquetes de visualización, en el tiempo preciso a fin de que sean útiles.

Si bien el tamaño empleado para determinar si un conjunto de datos determinado se considera Big Data no está firmemente definido y prosigue mudando con el tiempo, la mayor parte de los analistas y profesionales actualmente se refieren a conjuntos de datos que van desde 30-50 TB a varios Petabytes.

La naturaleza compleja del Big Data se debe primordialmente a la naturaleza no estructurada de una gran parte de los datos generados por las tecnologías modernas, como los web logs, la identificación por radiofrecuencia (RFID), los sensores incorporados en dispositivos, la maquinaria, los automóviles, las buscas en Internet, las redes sociales como Facebook, computadoras portátiles, teléfonos inteligentes y otros teléfonos móviles, dispositivos GPS y registros de centros de llamadas.

En la mayor parte de los casos, con el fin de usar de manera eficaz el Big Data, debe combinarse con datos estructurados (generalmente de una base de datos relacional) de una aplicación comercial más convencional, como un ERP (Enterprise Resource Planning) o un CRM (Customer Relationship Management).

¿Por qué razón el Big Data es tan importante?

Lo que hace que Big Data sea tan útil para muchas empresas es el hecho de que proporciona contestaciones a muchas preguntas que las empresas ni tan siquiera sabían que tenían. En otras palabras, da un punto de referencia. Con una cantidad tan grande de información, los datos pueden ser moldeados o probados de cualquier forma que la compañía considere adecuada. Al hacerlo, las organizaciones son capaces de identificar los inconvenientes de una manera más entendible.

La recopilación de grandes cantidades de datos y la búsqueda de tendencias dentro de los datos permiten que las empresas se muevan considerablemente más velozmente, sin inconvenientes y de manera eficaz. Asimismo les deja quitar las áreas problemáticas antes de que los problemas acaben con sus beneficios o bien su reputación.

El análisis de Big Data ayuda a las organizaciones a aprovechar sus datos y utilizarlos para identificar nuevas oportunidades. Eso, a su vez, conduce a movimientos de negocios más inteligentes, operaciones más eficientes, mayores ganancias y clientes más felices. Las compañías con más éxito con Big Data consiguen valor de las próximas formas:

Reducción de costo. Las grandes tecnologías de datos, como Hadoop y el análisis basado en la nube, aportan esenciales ventajas en concepto de costes cuando se trata de almacenar grandes cantidades de datos, además de identificar formas más eficaces de hacer negocios.

Más rápido, mejor toma de decisiones. Con la velocidad de Hadoop y la analítica en memoria, conjuntada con la capacidad de analizar nuevas fuentes de datos, las empresas pueden examinar la información de forma inmediata y tomar resoluciones basadas en lo que han aprendido.

Nuevos productos y servicios. Con la capacidad de medir las necesidades de los clientes del servicio y la satisfacción mediante análisis viene el poder de dar a los clientes del servicio lo que quieren. Con la analítica de Big Data, más empresas están creando nuevos productos para satisfacer las necesidades de los clientes.

New Call-to-action

Por ejemplo:

Turismo: Mantener felices a los clientes es clave para la industria del turismo, pero la satisfacción del cliente puede ser difícil de medir, singularmente en el momento oportuno. Resorts y casinos, por ejemplo, solo tienen una pequeña oportunidad de dar la vuelta a una mala experiencia de cliente. El análisis de Big data ofrece a estas empresas la capacidad de compendiar datos de los clientes, aplicar análisis e identificar de manera inmediata posibles problemas antes de que sea demasiado tarde.

Cuidado de la salud: El Big Data aparece en grandes cantidades en la industria sanitaria. Los registros de pacientes, planes de salud, información de seguros y otros géneros de información pueden ser difíciles de manejar, mas están llenos de información clave una vez que se aplican las analíticas. De ahí que que la tecnología de análisis de datos es tan importante para el cuidado de la salud. Al analizar grandes cantidades de información – tanto estructurada como no estructurada – rápidamente, se pueden administrar diagnósticos u opciones de tratamiento casi de inmediato.

Administración: La administración se encuentra frente a un gran desafío: sostener la calidad y la productividad con unos presupuestos ajustados. Esto es particularmente problemático con lo relacionado con la justicia. La tecnología agiliza las operaciones al tiempo que da a la administración una visión más holística de la actividad.

Retail: El servicio al usuario ha evolucionado en los últimos años, puesto que los compradores más inteligentes esperan que los minoristas entiendan precisamente lo que precisan, cuando lo necesitan. El Big Data ayuda a los minoristas a satisfacer esas demandas. Armados con cantidades inacabables de datos de programas de fidelización de clientes, hábitos de adquiere y otras fuentes, los minoristas no sólo tienen una entendimiento profunda de sus clientes, sino que asimismo pueden pronosticar tendencias, aconsejar nuevos productos y aumentar la rentabilidad.

Empresas manufactureras: Estas despliegan sensores en sus productos para percibir datos de telemetría. En ocasiones esto se utiliza para ofrecer servicios de comunicaciones, seguridad y navegación. Ésta telemetría también revela patrones de uso, tasas de fracaso y otras oportunidades de mejora de productos que pueden reducir los costos de desarrollo y montaje.

Publicidad: La proliferación de teléfonos inteligentes y otros dispositivos GPS ofrece a los anunciantes la oportunidad de dirigirse a los usuarios cuando están cerca de una tienda, una cafetería o un restorán. Esto abre nuevos ingresos para los distribuidores de servicios y ofrece a muchas empresas la ocasión de lograr nuevos prospectos.

Otros ejemplos del uso efectivo de Big Data existen en las siguientes áreas:

Uso de registros de logs de TI para prosperar la resolución de inconvenientes de TI, así como la detección de infracciones de seguridad, velocidad, eficacia y prevención de sucesos futuros.

Uso de la grande información histórica de un Call Center de forma rápida, con el objetivo de prosperar la interacción con el usuario y acrecentar su satisfacción.

Empleo de contenido de medios sociales para mejorar y entender más velozmente el sentimiento del cliente del servicio y prosperar los productos, los servicios y la interacción con el cliente.

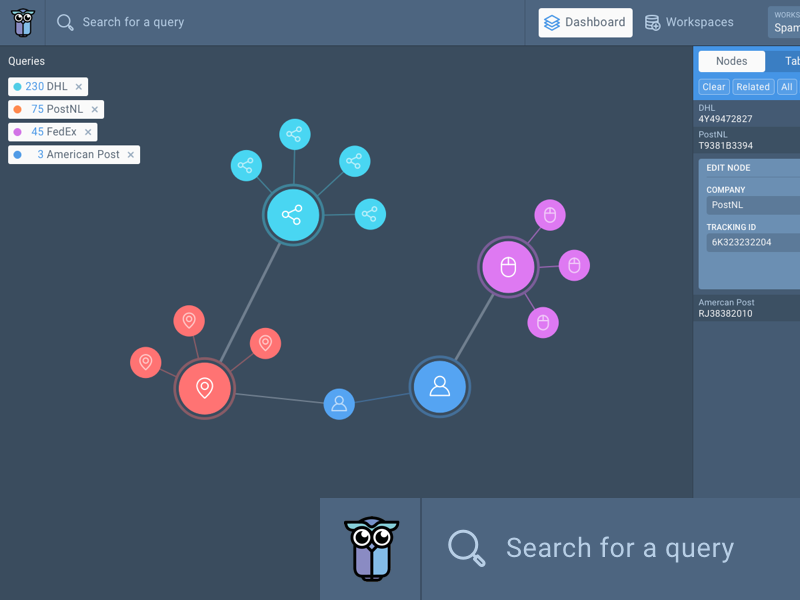

Detección y prevención de fraudes en cualquier industria que procese transacciones financieras en línea, tales como compras, actividades bancarias, inversiones, seguros y atención médica.

Uso de información de transacciones de mercados financieros para evaluar más velozmente el riesgo y tomar medidas correctivas.

Desafíos de la calidad de datos en Big Data

Las singulares características del Big Data hacen que su calidad de datos se enfrente a múltiples desafíos. Se trata de las conocidas como 5 Vs: Volumen, Velocidad, Pluralidad, Veracidad y Valor, que definen la problemática del Big Data.

Estas 5 características del big data provocan que las compañías tengan problemas para extraer datos reales y de alta calidad, de conjuntos de datos tan masivos, alterables y complicados.

Hasta la llegada del Big Data, a través de ETL podíamos cargar la información estructurada que teníamos almacenada en nuestro sistema ERP y CRM, por poner un ejemplo. Mas ahora, podemos cargar información adicional que ya no se halla en los dominios de la empresa: comentarios o bien likes en redes sociales, resultados de campañas de marketing, datos estadísticos de terceros, etcétera Todos estos datos nos ofrecen información que nos ayuda a saber si nuestros productos o bien servicios están marchando bien o por el contrario tienen problemas.

Ciertos retos a los que se encara la calidad de datos de Big Data son:

Muchas fuentes y tipos de datos

Con tantas fuentes, géneros de datos y estructuras complejas, la dificultad de integración de datos aumenta.

Las fuentes de datos de big data son muy amplias:

Datos de internet y móviles.

Datos de Internet de las Cosas.

Datos sectoriales compendiados por empresas especializadas.

Datos experimentales.

Y los tipos de datos también lo son:

Tipos de datos no estructurados: documentos, vídeos, audios, etcétera

Géneros de datos semi-estructurados: software, hojas de cálculo, informes.

Géneros de datos estructurados

Solo el veinte por ciento de información es estructurada y eso puede provocar muchos errores si no acometemos un proyecto de calidad de datos.

dos. Tremendo volumen de datos

Como ya hemos visto, el volumen de datos es enorme, y eso complica la ejecución de un proceso de calidad de datos dentro de un tiempo razonable.

Es difícil recolectar, limpiar, integrar y obtener datos de alta calidad de forma veloz. Se necesita mucho tiempo para convertir los modelos no estructurados en tipos estructurados y procesar esos datos.

tres. Mucha volatilidad

Los datos cambian velozmente y eso hace que tengan una valía cortísima. Para solventarlo necesitamos un poder de procesamiento muy alto.

Si no lo hacemos bien, el procesamiento y análisis basado en estos datos puede generar conclusiones erradas, que pueden llevar a cometer errores en la toma de resoluciones.

No existen estándares de calidad de datos unificados

En mil novecientos ochenta y siete la Organización Internacional de Normalización (ISO) publicó las reglas ISO 9000 para asegurar la calidad de productos y servicios. No obstante, el estudio de los estándares de calidad de los datos no empezó hasta los años noventa, y no fue hasta dos mil once cuando ISO publicó las reglas de calidad de datos ISO 8000.

Estas reglas precisan madurar y perfeccionarse. Además, la investigación sobre la calidad de datos de big data ha comenzado hace poco y no hay apenas resultados.

La calidad de datos de big data es clave, no solo para poder conseguir ventajas competitivas sino también impedir que incurramos en graves fallos estratégicos y operacionales basándonos en datos equivocados con consecuencias que pueden ser muy graves.

Cómo construir un plan de Data Governance en Big data

Gobernabilidad significa cerciorarse de que los datos estén autorizados, organizados y con los permisos de usuario necesarios en una base de datos, con el menor número posible de errores, sosteniendo al mismo tiempo la privacidad y la seguridad.

Esto no semeja un equilibrio fácil de lograr, especialmente cuando la realidad de dónde y de qué forma los datos se alojan y procesan está en incesante movimiento.

A continuación vamos a ver ciertos pasos recomendados al crear un plan de Data Governance en Big Data.

1. Acceso y Autorización Granular a Datos

No se puede tener un gobierno de datos efectivo sin controles granulares.

Se pueden conseguir estos controles granulares por medio de las expresiones de control de acceso. Estas expresiones emplean agrupación y lógica booleana para controlar el acceso y autorización de datos flexibles, con permisos basados en papeles y configuraciones de visibilidad.

En el nivel más bajo, se resguardan los datos confidenciales, ocultándolos, y en la parte superior, se tienen contratos confidenciales para científicos de datos y analistas de BI. Esto se puede hacer con capacidades de enmascaramiento de datos y diferentes vistas donde se bloquean los datos en bárbaro tanto como sea posible y gradualmente se proporciona más acceso hasta que, en la parte superior, se da a los administradores una mayor visibilidad.

Se pueden tener diferentes niveles de acceso, lo que da una seguridad más integrada.

Consulta a un experto para implementar un proyecto de Gobierno de datos

2. Seguridad perimetral, protección de datos y autenticación integrada

La gobernabilidad no ocurre sin una seguridad en el punto y final de la cadena. Es importante edificar un buen perímetro y colocar un cortafuegos cerca de los datos, integrados con los sistemas y estándares de autenticación existentes. Cuando se trata de autentificación, es importante que las compañías se sincronicen con sistemas probados.

Con la autentificación, se trata de ver de qué manera integrarse con LDAP [Lightweight Directory Access Protocol], Active Directory y otros servicios de directorio. Asimismo se puede dar soporte a herramientas como Kerberos para soporte de autentificación. Mas lo importante es no crear una infraestructura separada, sino más bien integrarla en la estructura existente.

3. Encriptación y Tokenización de Datos

El próximo paso tras proteger el perímetro y autentificar todo el acceso granular de datos que se está dando es asegúrese de que los archivos y la información personalmente reconocible (PII) estén cifrados y tokenizados de extremo a extremo del pipeline de datos.

Una vez superado el perímetro y con acceso al sistema, resguardar los datos de PII es extremadamente importante. Es preciso encriptar esos datos de manera que, independientemente de quién tenga acceso a él, puedan ejecutar los análisis que precisen sin exponer ninguno de esos datos.

cuatro. Constante Auditoría y Análisis

La estrategia no funciona sin una auditoría. Ese nivel de visibilidad y responsabilidad en cada paso del proceso es lo que deja a la TI «regir» los datos en lugar de sencillamente establecer políticas y controles de acceso y aguardar lo mejor. También es de qué forma las empresas pueden sostener sus estrategias actualizadas en un entorno en el que la forma en que vemos los datos y las tecnologías que usamos para administrarlos y examinarlos cambian día a día.

Estamos en la infancia de Big Data e IoT (Internet de Cosas), y es esencial poder rastrear el acceso y reconocer patrones en los datos.

La auditoría y el análisis pueden ser tan simples como el seguimiento de los archivos de JavaScript Object Notation (JSON).

Una arquitectura de datos unificada

En última instancia, el encargado de TI que inspeccionar la estrategia de administración de datos empresariales, debe meditar en los detalles del acceso granular, la autenticación, la seguridad, el cifrado y la auditoría. Pero no debe detenerse ahí. Más bien debe meditar en de qué manera cada uno de ellos de estos componentes se integra en su arquitectura de datos global. También debe meditar en cómo esa infraestructura va a precisar ser escalable y segura, desde la recolección de datos y almacenamiento hasta BI, analítica y otros servicios de terceros. La gobernanza de los datos es tanto sobre repensar la estrategia y la ejecución como sobre la propia tecnología.

Va alén de un conjunto de reglas de seguridad. Es una arquitectura única en la que se crean estos papeles y se sincronizan mediante toda la plataforma y todas las herramientas que se aportan a ella.

Noticias de Big Data